在當今大數據時代,Hadoop作為分布式計算框架的核心,其集群的構建與擴展能力直接關系到數據處理效率。構建一個可伸縮的Hadoop集群,不僅能應對數據量的動態增長,還能優化資源利用率。下面,我們將基于實戰經驗,詳細闡述構建可伸縮Hadoop集群的方法與步驟,以供IT168技術開發專區的網絡科技開發者參考。

一、準備階段:環境規劃與硬件選型

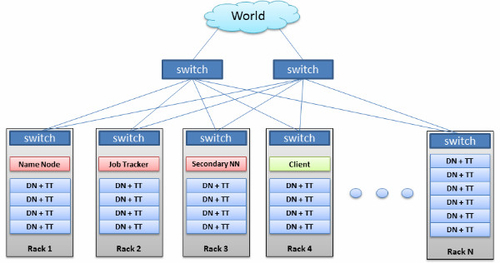

在開始構建集群前,需進行充分的準備工作。評估業務需求,確定預期的數據量、處理速度和容錯要求。然后,選擇適合的硬件:主節點(如NameNode和ResourceManager)應配備高性能CPU、大內存和可靠存儲;數據節點(如DataNode和NodeManager)則可使用標準服務器,注重磁盤容量和網絡帶寬。建議采用虛擬化或云平臺(如AWS EMR或阿里云EMR)以增強伸縮性,同時確保所有節點運行相同版本的操作系統(如CentOS或Ubuntu)和Java環境。

二、軟件安裝與配置:Hadoop核心組件部署

安裝Hadoop是集群構建的關鍵步驟。下載并解壓Hadoop發行版(如Apache Hadoop 3.x)。接著,配置核心文件:修改core-site.xml設置文件系統URI(如hdfs://namenode:9000),在hdfs-site.xml中定義數據塊副本數和存儲路徑,并配置yarn-site.xml以啟用資源管理。例如,將ResourceManager指定為主節點,NodeManager部署于數據節點。確保所有節點間的SSH無密碼登錄已設置,以便自動化管理。使用工具如Ansible或Puppet可簡化多節點部署過程。

三、集群初始化與測試

完成配置后,初始化HDFS:在主節點運行hdfs namenode -format命令格式化文件系統,然后啟動HDFS和YARN服務。使用start-dfs.sh和start-yarn.sh腳本啟動集群,并通過Web UI(如http://namenode:9870)驗證服務狀態。運行簡單測試,例如上傳文件到HDFS并執行MapReduce作業,確保數據分布和計算功能正常。記錄日志以排查潛在問題,如網絡連接或權限錯誤。

四、實現可伸縮性:動態擴展與優化

構建可伸縮集群的核心在于支持動態擴展。對于水平擴展,新增數據節點時,只需安裝Hadoop軟件、復制配置文件并啟動服務,集群會自動識別新節點。使用負載均衡工具(如HAProxy)可優化資源分配。配置HDFS的機架感知策略,提升數據本地性和容錯能力。定期監控集群性能,使用工具如Ambari或Cloudera Manager調整參數(如內存分配和任務調度),并實施自動化伸縮策略,例如基于CPU使用率自動添加或移除節點。

五、運維與管理:監控與故障處理

可伸縮集群的運維至關重要。部署監控系統(如Prometheus和Grafana)跟蹤關鍵指標,如節點健康狀況、存儲使用率和作業延遲。設置警報機制,及時發現故障。對于常見問題,如節點失效或數據損壞,實施備份和恢復策略,例如使用HDFS快照或復制數據到備用集群。定期更新Hadoop版本和安全補丁,確保集群長期穩定運行。

結語

通過以上步驟,開發者可以構建一個高效、可伸縮的Hadoop集群,適應不斷變化的數據需求。關鍵在于前期規劃、標準化部署和持續優化。在IT168技術開發專區,我們鼓勵用戶結合實際場景進行實驗,分享經驗以推動網絡科技領域的創新。如有疑問,歡迎在專區論壇交流討論,共同提升大數據處理能力。